Obiettivi | Certificazione | Contenuti | Tipologia | Prerequisiti | Durata e Frequenza | Docenti | Modalità di Iscrizione | Calendario

Il Corso Data Engineering on Google Cloud fornisce ai partecipanti le competenze necessarie per progettare e costruire sistemi di elaborazione dei dati, analizzare i dati e implementare il machine learning utilizzando Google Cloud. Il corso si concentra su dati strutturati, non strutturati e in streaming e richiede una conoscenza di base in SQL, modellazione dei dati, attività ETL e linguaggi di programmazione come Python. È ideale per gli sviluppatori che si occupano di elaborazione dei dati, analisi e machine learning. Durante il corso, i partecipanti approfondiranno vari argomenti, tra cui il ruolo di un ingegnere dei dati, BigQuery, data lakes, data warehouses e la collaborazione con altri team di dati. Le tecnologie che saranno esplorate includono Google Cloud, SQL, Python, BigQuery, data lakes e data warehouses. Infine, il corso contribuisce alla preparazione per l’esame di Certificazione Google Professional Data Engineer.

Contattaci ora per ricevere tutti i dettagli e per richiedere, senza alcun impegno, di parlare direttamente con uno dei nostri Docenti (Clicca qui)

oppure chiamaci subito al nostro Numero Verde (800-177596).

Calling from abroad? Reach us at +39 02 87168254.

Obiettivi del corso

Di seguito una sintesi degli obiettivi principali del Corso Data Engineering on Google Cloud:

- Imparare a utilizzare Google Cloud per la progettazione e costruzione di soluzioni di data engineering.

- Esplorare le funzionalità avanzate di BigQuery per l’analisi di grandi dataset.

- Applicare tecniche di data modeling e processi ETL all’interno dell’ecosistema Google Cloud.

- Sviluppare competenze in machine learning con gli strumenti di Google Cloud.

- Integrare servizi di data lake e data warehouse per l’archiviazione e l’analisi dei dati su Google Cloud.

Certificazione del corso

Esame Google Cloud Certified Professional Data Engineer; L’esame misura la capacità di progettare, costruire e gestire soluzioni di elaborazione dati sicure e scalabili su Google Cloud Platform. Testa conoscenze specialistiche in servizi come BigQuery per l’analisi di grandi dataset, Cloud Dataflow per la costruzione di pipeline di dati, e Cloud Dataproc per l’elaborazione di workload Hadoop/Spark. L’esame richiede anche competenze nella gestione di modelli di machine learning e nella scelta delle migliori strategie di storage e gestione dei dati. Candidati devono dimostrare l’uso efficace di Python e SQL per manipolare e analizzare i dati all’interno dell’ecosistema GCP.

Contenuti del corso

Module 1: Introduction to Data Engineering

- Explore the role of a data engineer.

- Analyze data engineering challenges.

- Intro to BigQuery.

- Data Lakes and Data Warehouses.

- Demo: Federated Queries with BigQuery.

- Transactional Databases vs Data Warehouses.

- Website Demo: Finding PII in your dataset with DLP API.

- Partner effectively with other data teams.

- Manage data access and governance.

- Build production-ready pipelines.

- Review GCP customer case study.

- Lab: Analyzing Data with BigQuery.

Module 2: Building a Data Lake

- Introduction to Data Lakes.

- Data Storage and ETL options on GCP.

- Building a Data Lake using Cloud Storage.

- Optional Demo: Optimizing cost with Google Cloud Storage classes and Cloud Functions.

- Securing Cloud Storage.

- Storing All Sorts of Data Types.

- Video Demo: Running federated queries on Parquet and ORC files in BigQuery.

- Cloud SQL as a relational Data Lake.

- Lab: Loading Taxi Data into Cloud SQL.

Module 3: Building a Data Warehouse

- The modern data warehouse.

- Intro to BigQuery.

- Demo: Query TB+ of data in seconds.

- Getting Started.

- Loading Data.

- Video Demo: Querying Cloud SQL from BigQuery.

- Lab: Loading Data into BigQuery.

- Exploring Schemas.

- Demo: Exploring BigQuery Public Datasets with SQL using INFORMATION_SCHEMA.

- Schema Design.

- Nested and Repeated Fields.

- Demo: Nested and repeated fields in BigQuery.

- Lab: Working with JSON and Array data in BigQuery.

- Optimizing with Partitioning and Clustering.

- Demo: Partitioned and Clustered Tables in BigQuery.

- Preview: Transforming Batch and Streaming Data.

Module 4: Introduction to Building Batch Data Pipelines

- EL, ELT, ETL.

- Quality considerations.

- How to carry out operations in BigQuery.

- Demo: ELT to improve data quality in BigQuery.

- Shortcomings.

- ETL to solve data quality issues.

Module 5: Executing Spark on Cloud Dataproc

- The Hadoop ecosystem.

- Running Hadoop on Cloud Dataproc.

- GCS instead of HDFS.

- Optimizing Dataproc.

- Lab: Running Apache Spark jobs on Cloud Dataproc.

Module 6: Serverless Data Processing with Cloud Dataflow

- Cloud Dataflow.

- Why customers value Dataflow.

- Dataflow Pipelines.

- Lab: A Simple Dataflow Pipeline (Python/Java).

- Lab: MapReduce in Dataflow (Python/Java).

- Lab: Side Inputs (Python/Java).

- Dataflow Templates.

- Dataflow SQL.

Module 7: Manage Data Pipelines with Cloud Data Fusion and Cloud Composer

- Building Batch Data Pipelines visually with Cloud Data Fusion.

- Components.

- UI Overview.

- Building a Pipeline.

- Exploring Data using Wrangler.

- Lab: Building and executing a pipeline graph in Cloud Data Fusion.

- Orchestrating work between GCP services with Cloud Composer.

- Apache Airflow Environment.

- DAGs and Operators.

- Workflow Scheduling.

- Optional Long Demo: Event-triggered Loading of data with Cloud Composer, Cloud Functions, Cloud Storage, and BigQuery.

- Monitoring and Logging.

- Lab: An Introduction to Cloud Composer.

Module 8: Introduction to Processing Streaming Data

- Processing Streaming Data.

Module 9: Serverless Messaging with Cloud Pub/Sub

- Cloud Pub/Sub.

- Lab: Publish Streaming Data into Pub/Sub.

Module 10: Cloud Dataflow Streaming Features

- Cloud Dataflow Streaming Features.

- Lab: Streaming Data Pipelines.

Module 11: High-Throughput BigQuery and Bigtable Streaming Features

- BigQuery Streaming Features.

- Lab: Streaming Analytics and Dashboards.

- Cloud Bigtable.

- Lab: Streaming Data Pipelines into Bigtable.

Module 12: Advanced BigQuery Functionality and Performance

- Analytic Window Functions.

- Using With Clauses.

- GIS Functions.

- Demo: Mapping Fastest Growing Zip Codes with BigQuery GeoViz.

- Performance Considerations.

- Lab: Optimizing your BigQuery Queries for Performance.

- Optional Lab: Creating Date-Partitioned Tables in BigQuery.

Module 13: Introduction to Analytics and AI

- What is AI?.

- From Ad-hoc Data Analysis to Data Driven Decisions.

- Options for ML models on GCP.

Module 14: Prebuilt ML model APIs for Unstructured Data

- Unstructured Data is Hard.

- ML APIs for Enriching Data.

- Lab: Using the Natural Language API to Classify Unstructured Text.

Module 15: Big Data Analytics with Cloud AI Platform Notebooks

- Whats a Notebook.

- BigQuery Magic and Ties to Pandas.

- Lab: BigQuery in Jupyter Labs on AI Platform.

Module 16: Production ML Pipelines with Kubeflow

- Ways to do ML on GCP.

- Kubeflow.

- AI Hub.

- Lab: Running AI models on Kubeflow.

Module 17: Custom Model building with SQL in BigQuery ML

- BigQuery ML for Quick Model Building.

- Demo: Train a model with BigQuery ML to predict NYC taxi fares.

- Supported Models.

- Lab Option 1: Predict Bike Trip Duration with a Regression Model in BQML.

- Lab Option 2: Movie Recommendations in BigQuery ML.

- Module 18: Custom Model building with Cloud AutoML

- Why Auto ML?

- Auto ML Vision.

- Auto ML NLP.

- Auto ML Tables.

Tipologia

Corso di Formazione con Docente

Docenti

I docenti sono Istruttori accreditati Google Cloud e certificati in altre tecnologie IT, con anni di esperienza pratica nel settore e nella Formazione.

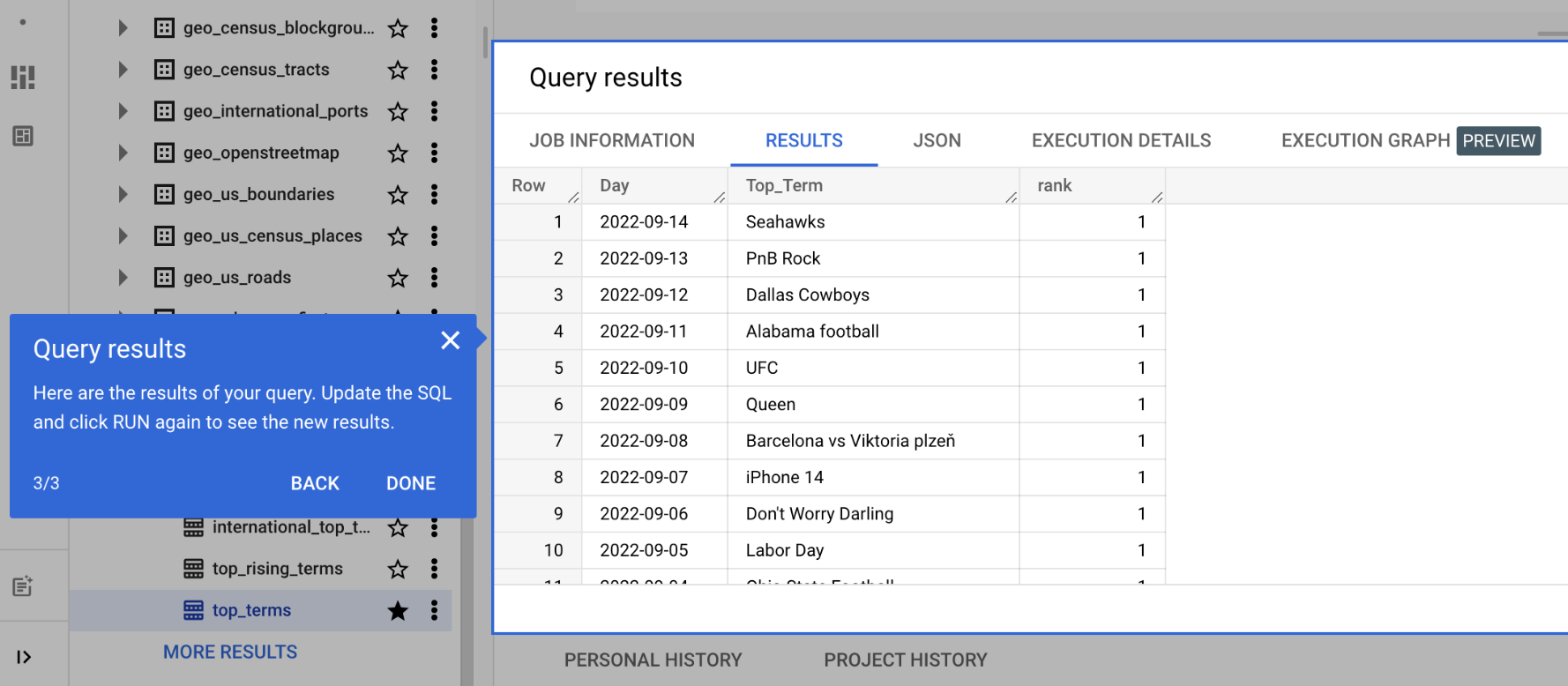

Infrastruttura laboratoriale

Per tutte le tipologie di erogazione, il Corsista può accedere alle attrezzature e ai sistemi presenti nei Nostri laboratori o direttamente presso i data center del Vendor o dei suoi provider autorizzati in modalità remota h24. Ogni partecipante dispone di un accesso per implementare le varie configurazioni avendo così un riscontro pratico e immediato della teoria affrontata. Ecco di seguito alcuni scenari tratti dalle attività laboratoriali:

Dettagli del corso

Prerequisiti

Si consiglia la partecipazione al Corso Google Cloud Big Data and Machine Learning Fundamentals.

Durata del corso

- Durata Intensiva 4gg;

Frequenza

Varie tipologie di Frequenza Estensiva ed Intensiva.

Date del corso

- Corso Data Engineering on Google Cloud (Formula Intensiva) – 09/06/2025 – 9:00 – 17:00 – English

Modalità di iscrizione

Le iscrizioni sono a numero chiuso per garantire ai tutti i partecipanti un servizio eccellente.

L’iscrizione avviene richiedendo di essere contattati dal seguente Link, o contattando la sede al numero verde 800-177596 o inviando una richiesta all’email contatti@vegatraining.eu.