Obiettivi | Certificazione | Contenuti | Tipologia | Prerequisiti | Durata e Frequenza | Docenti | Modalità di Iscrizione | Calendario

Il Corso Serverless Data Processing with Dataflow di Google Cloud è un programma di formazione progettato per i professionisti del big data che aspirano a potenziare le loro competenze in Dataflow e migliorare le applicazioni di elaborazione dati. Il corso si sviluppa partendo dalle fondamenta, illustrando come Apache Beam e Dataflow collaborano per rispondere alle esigenze di elaborazione dati, evitando il rischio di dipendenza da un singolo fornitore. Successivamente, il corso si concentra sullo sviluppo di pipeline, spiegando come trasformare la logica aziendale in applicazioni di elaborazione dati che possono funzionare su Dataflow. La parte finale del corso è dedicata alle operazioni, dove vengono affrontati aspetti cruciali per la gestione di un’applicazione di dati su Dataflow, come il monitoraggio, la risoluzione dei problemi, i test e l’affidabilità. Durante il corso, i partecipanti avranno l’opportunità di familiarizzare con tecnologie come il Beam Portability Framework, Shuffle and Streaming Engine, Flexible Resource Scheduling e IAM. Infine, il corso contribuisce alla preparazione per l’esame di Certificazione Google Professional Data Engineer.

Contattaci ora per ricevere tutti i dettagli e per richiedere, senza alcun impegno, di parlare direttamente con uno dei nostri Docenti (Clicca qui)

oppure chiamaci subito al nostro Numero Verde (800-177596).

Calling from abroad? Reach us at +39 02 87168254.

Obiettivi del corso

Di seguito una sintesi degli obiettivi principali del Corso Serverless Data Processing with Dataflow:

- Comprendere l’integrazione e l’uso di Apache Beam con Dataflow.

- Sviluppare pipeline di dati scalabili e serverless.

- Applicare pratiche operative per la gestione di applicazioni Dataflow.

- Utilizzare tecnologie come il Beam Portability Framework e il Flexible Resource Scheduling.

- Prepararsi per l’esame di Certificazione Google Professional Data Engineer

Certificazione del corso

Esame Google Cloud Certified Professional Data Engineer; L’esame misura la capacità di progettare, costruire e gestire soluzioni di elaborazione dati sicure e scalabili su Google Cloud Platform. Testa conoscenze specialistiche in servizi come BigQuery per l’analisi di grandi dataset, Cloud Dataflow per la costruzione di pipeline di dati, e Cloud Dataproc per l’elaborazione di workload Hadoop/Spark. L’esame richiede anche competenze nella gestione di modelli di machine learning e nella scelta delle migliori strategie di storage e gestione dei dati. Candidati devono dimostrare l’uso efficace di Python e SQL per manipolare e analizzare i dati all’interno dell’ecosistema GCP.

Contenuti del corso

Module 1: Introduction

- Course Introduction

- Beam and Dataflow Refresher

Module 2: Separating Compute and Storage with Dataflow

- Dataflow

- Beam Portability

- Runner v2

- Container Environments

- Cross-Language Transforms

Module 3: Dataflow, Cloud Operations

- Dataflow Shuffle Service

- Dataflow Streaming Engine

- Flexible Resource Scheduling

Module 4: IAM, Quotas, and Permissions

- IAM

- Quota

Module 5: Security

- Data Locality

- Shared VPC

- Private IPs

- CMEK

Module 6: Beam Concepts Review

- Beam Basics

- Utility Transforms

- DoFn Lifecycle

Module 7: Windows, Watermarks, Triggers

- Windows

- Watermarks

- Triggers

Module 8: Sources and Sinks

- Sources and Sinks

- Text IO and File IO

- BigQuery IO

- PubSub IO

- Kafka IO

- Bigtable IO

- Avro IO

- Splittable DoFn

Module 9: Schemas

- Beam Schemas

- Code Examples

Module 10: State and Timers

- State API

- Timer API

Module 11: Best Practices

- Schemas

- Handling unprocessable Data

- Error Handling

- AutoValue Code Generator

- JSON Data Handling

- Utilize DoFn Lifecycle

- Pipeline Optimizations

Module 12: Dataflow SQL and DataFrames

- Dataflow and Beam SQL

- Windowing in SQL

- Beam DataFrames

Module 13: Beam Notebooks

- Beam Notebooks

Module 14: Monitoring

- Job List

- Job Info

- Job Graph

- Job Metrics

- Metrics Explorer

Module 15: Logging and Error Reporting

- Logging

- Error Reporting

Module 16: Troubleshooting and Debug

- Troubleshooting Workflow

- Types of Troubles

Module 17: Performance

- Pipeline Design

- Data Shape

- Source, Sinks, and External Systems

- Shuffle and Streaming Engine

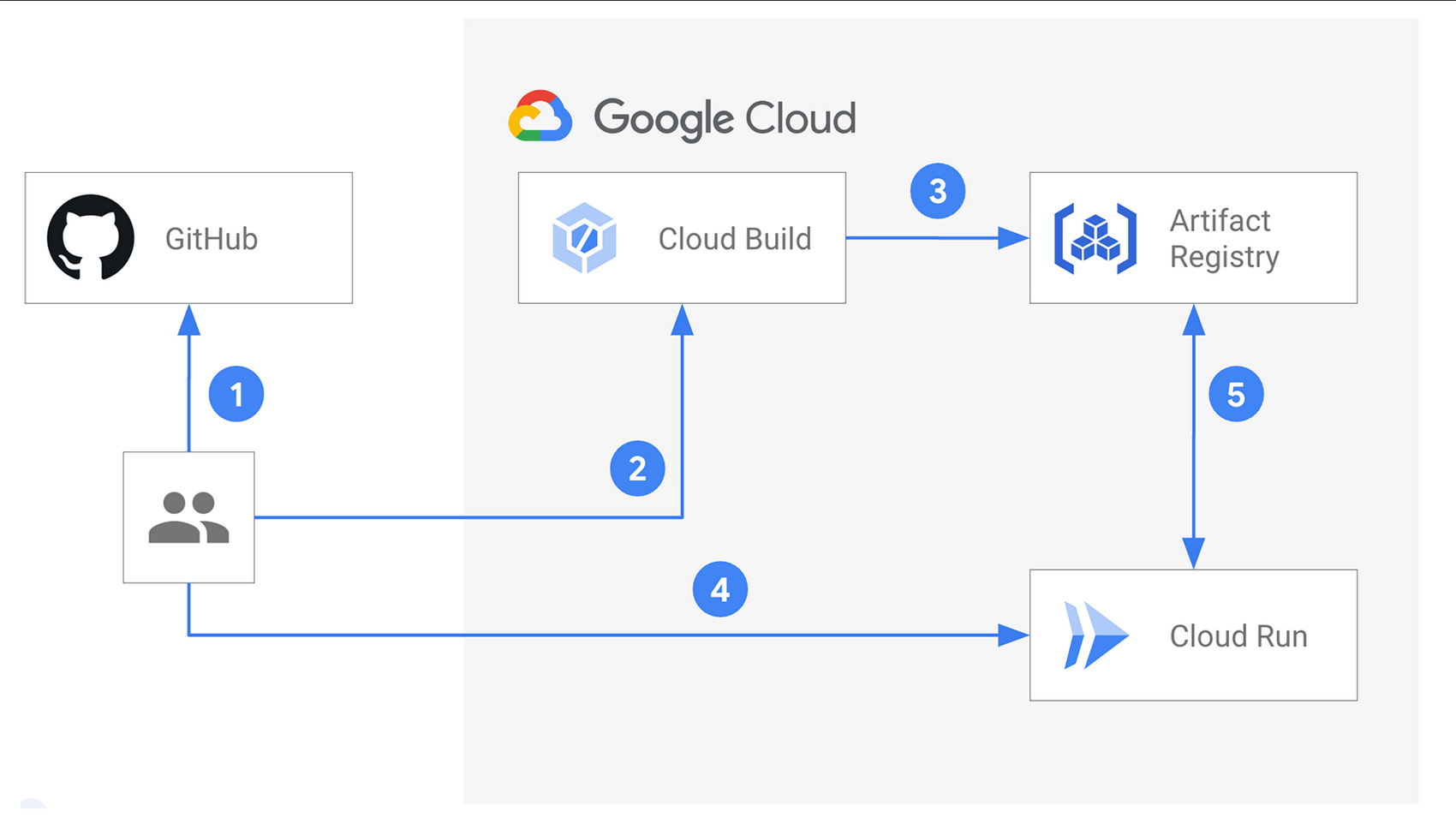

Module 18: Testing and CI/CD

- Testing and CI/CD Overview

- Unit Testing

- Integration Testing

- Artifact Building

- Deployment

Module 19: Reliability

- Introduction to Reliability

- Monitoring

- Geolocation

- Disaster Recovery

- High Availability

Module 20: Flex Templates

- Classic Templates

- Flex Templates

- Using Flex Templates

- Google-provided Templates

Tipologia

Corso di Formazione con Docente

Docenti

I docenti sono Istruttori accreditati Google Cloud e certificati in altre tecnologie IT, con anni di esperienza pratica nel settore e nella Formazione.

Infrastruttura laboratoriale

Per tutte le tipologie di erogazione, il Corsista può accedere alle attrezzature e ai sistemi presenti nei Nostri laboratori o direttamente presso i data center del Vendor o dei suoi provider autorizzati in modalità remota h24. Ogni partecipante dispone di un accesso per implementare le varie configurazioni avendo così un riscontro pratico e immediato della teoria affrontata. Ecco di seguito alcuni scenari tratti dalle attività laboratoriali:

Dettagli del corso

Prerequisiti

Si consiglia la partecipazione al Corso Data Engineering on Google Cloud.

Durata del corso

- Durata Intensiva 3gg;

Frequenza

Varie tipologie di Frequenza Estensiva ed Intensiva.

Date del corso

- Corso Serverless Data Processing with Dataflow (Formula Intensiva) – 25/06/2025 – 9:00 – 17:00 – English

Modalità di iscrizione

Le iscrizioni sono a numero chiuso per garantire ai tutti i partecipanti un servizio eccellente.

L’iscrizione avviene richiedendo di essere contattati dal seguente Link, o contattando la sede al numero verde 800-177596 o inviando una richiesta all’email contatti@vegatraining.eu.